在自动驾驶路线上,特斯拉一直是特立独行的。坚持在纯视觉路线,让它与那些武装到牙齿的竞争对手们,形成鲜明对立。

当然,它有这个条件,或者说资格去这样做。

目前,特斯拉的全自动驾驶方案,依然在Beta版本,已经有两年时间没有重大更新了。

虽然现在的AutoPilot具有所谓的完全自动驾驶能力,但特斯拉在官网特别声明了一点,那就是车辆尚未实现完全自动驾驶。

也就是说,有这个能力,有这个硬件配置,但是呢,还没有真正实现所谓的Full Self Driving。未来通过OTA升级,就可以一步步提高自动驾驶的水平。

那么这句话,其实有一个前提,那就是现在AutoPilot第三代硬件,已经基本定型,确定了纯视觉方案。

未来除了会提高处理器性能,基本就沿着这条线去走了。

2019年4月,特斯拉发布了第三代自动驾驶的硬件。放弃了英伟达Drive PX 2平台,转而采用自己研发的SoC。这个时候,特斯拉的感知硬件是1个前置毫米波雷达、8个摄像头和12个超声波传感器。

2021年5月,这个前置毫米波雷达被取消,只保留了8个摄像头和12个超声波传感器。8个摄像头,前面3个,车身两侧,向前看、向后看各两个,然后再加一个倒车影像的摄像头,一共就是8个。

凭借这8个摄像头,特斯拉能实现全自动驾驶吗?

有人说,不是还有12个超声波传感器吗?这个超声波传感器,主要是车辆在停车的时候,感知周围物体的距离用的,比如自动泊车、召唤功能,是需要借助这些硬件的,我们人工去停车的时候,或者在比较狭窄的道路行驶的时候,也要借助超声波传感器来判断与物体的距离。

当然,在开启自动驾驶时,超声波传感器也会侦测附近车辆,但起到的作用有限。

因为它的感应距离只有8m,而超声波相对来说比较迟钝,不适合高速行驶的工况。

那么这个时候,特斯拉的自动驾驶,其实就是8个摄像头作为图像采集,然后凭借车载的SoC芯片进行实时的运算。

这8个摄像头,真的只是摄像头而已,CMOS传感器用的是安森美半导体的,它们只负责采集图像,分辨率是1280x960,总共才120万像素,像素大小是3.75um。

这跟蔚来ET7的800万像素摄像头比起来,简直是寒碜到家。当然,自动驾驶的视觉传感,不见得像素高就是有绝对优势。我们下篇文章再分析蔚来ET7的自动驾驶配置。

120万像素,听上去很鸡肋,但是它有一个巨大的优势,那就是成本低。Model 3的前置三摄系统,总共才65美元。用最便宜(但是够用)的硬件,做出最潮流的产品,这不正是特斯拉的看家本事吗?

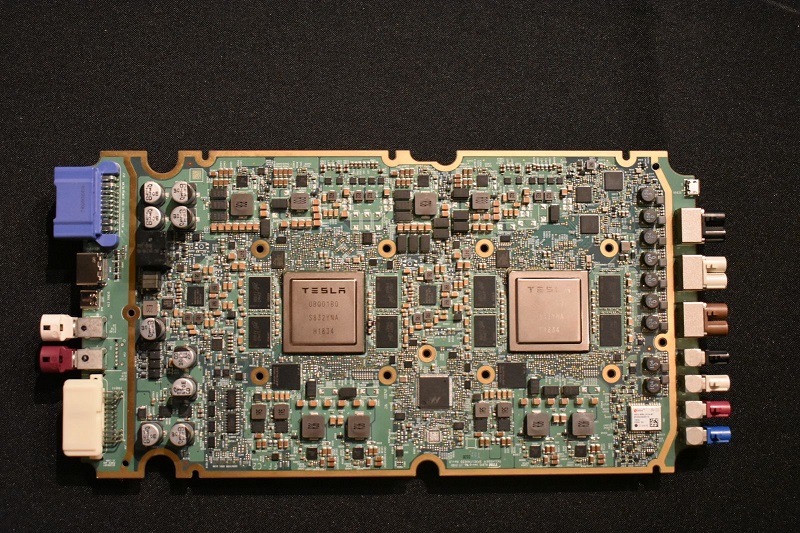

接下来,我们来看下特斯拉自动驾驶的主板是什么配置的?在3.0版本上,特斯拉集成了两个自研的SoC。用了三星的14nm FinFET工艺,单个SoC有60亿晶体管。

后续,特斯拉应该会向10nm甚至7nm进发。

这里顺便说下,其实对于车规级芯片,并不像移动设备那样追求几纳米的工艺,因为车载PCB的空间足够大,能承载非常大的die size。

但是,降低芯片制程,显而易见的好处是能耗会进一步降低。

整个FSD主板,具备144TOPS的算力,比起蔚来ET7那超过1000TOPS的算力,再次显得鸡肋。实际上在两个SoC中,有一个就是冗余备用的。

不过相比2.5代版本,3代硬件每秒可以处理2300帧画面,而上一代只有110帧。

从2.5到3.0,性能提升了一大截。

这是因为特斯拉在为后续的全自动驾驶铺路。

先把性能做上来,然后让老车主逐步更新软件部分,获得更多自动驾驶能力。这样的话,特斯拉就可以新老韭菜一起割。

以这张图为例,我们简单讲解一下。

可以看到,两组SoC并列,每个SoC两侧是内存,每个内存颗粒是2G,规格为LPDDR4。

也就是说每组SoC有8G的运行内容。两个芯片采用的都是BGA封装工艺。另外,每组SoC左下角的黑块是闪存,每个闪存应该是32G。

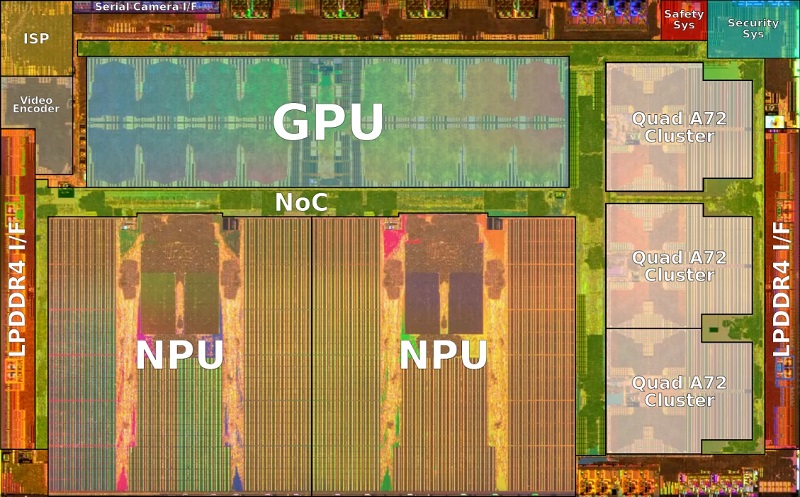

下面我们潜入单个SoC中,看一下具体的配置。

BGA封装拆开,就是这个样子的。

这是带有注解的图。

内部晶体管布局一览无余。

最右侧的是三组四核的Cortex A72处理器,作为CPU。

中间部分,上面是GPU,采用的是Mali G71 MP12;下面是NPU。注意左侧有一个Video Encoder,这个是特斯拉行车记录仪的h.265编码硬件。

那么我们重点说两个地方。

先看左上角的ISP。

ISP指的是Image Signal Processor,用于图像处理的,每秒可以处理10亿像素的数据。

ISP的角色是非常重要的,它的处理结果,很大程度上决定了电脑能否看懂当前的画面。特斯拉采用的ISP具备Tone mapping色调映射能力,什么意思呢?

因为8个摄像头采集的画面是HDR画面,也就是高动态范围,如果处理器直接对图像进行线性归一,那么获得的画面与人眼看到的会有天壤之别。

所以Tone Mapping算法就是把HDR映射为LDR,让动态范围降低,从而获得更现实的画面。

为什么要用LDR图像呢?因为HDR的数据量实在太大了,就像你用单反拍照,你用raw格式记录,但要处理成jpg才方便传播。

所以Tone Mapping的作用就是把raw变成jpg,同时保证颜色真实的一个过程。另外除了色调映射,ISP还负责对采集的图像进行降噪。

再看占地面积最大的NPU。

我们所说的算力,就是指这个NPU的性能。

话说,如今智能电动车时代,算力成为了一个新的性能参数。

特斯拉的NPU是自己设计的,那么以后车企掌握自主NPU设计能力,应该是个趋势。

NPU,神经网络处理单元。

CPU负责逻辑运算,GPU负责图像运算,那么NPU是干什么的?

NPU其实是通过电路来模拟人的神经元和突触的一种AI芯片,它是存储和计算一体化架构。

本质上,在自动驾驶这个领域,NPU就是学习怎么开车的。

如果只有CPU和GPU,系统也可以跑深度学习,但效率和能耗就不占优势了。

所以专门设计出NPU架构,来执行特定的算法。

它就像一头拉磨的驴,疯狂的原地转圈,但是每转一圈,这头驴都能收获新的技能来改善拉磨的效率。

要注意,NPU是不能单独工作的,它是给CPU做协同的。

所以NPU实际上是一种AI加速芯片。

它属于ASIC芯片的范畴。

换句话说,就是专门为某一算法设计一个硬件逻辑。

由于定制化和专用性,NPU的效率要大大高于CPU和GPU。

特斯拉的FSD够不够聪明,就是依赖于这个NPU的算力。

你可以理解为,算力越强,它的学习能力就越强。

对于自动驾驶来说,它的决策能力就会加强。

所以我们讨论自动驾驶的纯视觉路线,就是讨论NPU这种AI芯片,能否取代人脑来开车。

一个自动驾驶系统,在路上行驶,首先它要根据高精度地图和GPS知道自己的位置,我在哪条路上?然后,摄像头采集周围的画面,告诉电脑,你的环境是什么样子的?

周围的环境能否看懂?取决于电脑的图像识别能力,而图像识别依赖的就是NPU的加速运算。

那么这个时候我要变道,于是我拨动了特斯拉的转向灯拨杆,车辆预备变道,它要判断能不能变道,有没有车过来,如果有车过来,几秒钟内会以哪几种姿态撞车,如何才能避免撞车,最终得出一个结论,变还是不变。

这一系列操作,就是CPU在NPU的神经运算的配合下得出的结果。所以NPU为什么是存储和计算一体化的架构,因为要速度要快,而且吞吐量要大。所以NPU它本身不是一个大脑,真正的大脑还是CPU,但是NPU可以快速的告诉CPU结果,让CPU去发出最后的指令。

理论上,从三个方面讲:

第一,NPU的算力足够大的时候,比如说达到了10000TOPS,它的世界观就更加清晰,本地决策能力可能已经接近人的认知水平;

第二,AI算法。一个神经网络够不够聪明,除了我很能算以外,我的脑回路也要够高级,特斯拉的Dojo超级算计机,就是在不断优化AI算法模型,来提升自动驾驶的思考能力;

第三,这个摄像头的视觉信号采集能力,以及ISP和GPU的图形解析能力,代表了电脑的视力如何。就像人眼一样,眼神好的和近视眼开车的时候,那是两码事。

所以依靠纯视觉,理论上是可以实现较高水平的自动驾驶的。只是这个过程,依赖于大量的数据做支撑。

另外一个感知方案激光雷达,就有些来势汹汹了。

纯视觉和激光雷达到底哪个是趋势?还很难说,各有千秋。纯视觉方案成本低,但是依赖长期的、大量的数据训练,因为从2D画面提取3D特征,是非常难的一件事,比如纯视觉方案中,对于周边车辆的车身长度的判断就不够准确。

那么激光雷达呢,显然它的感知能力更强一些,对物体的小大和形状的判断比较精准。深度和速度信息的获取,要更具优势一些。

在这里,大家要明白一点,视觉也好,激光雷达也好,他们都会受到极端天气、强自然光、光污染的影响。不存在激光雷达更能经受恶劣条件这一说。相反,激光雷达即便做到车规级,也是高精密仪器,比一个摄像头要更娇贵。

所以你会发现,很多搭载了激光雷达的车,也都同时配有毫米波和摄像头,来实现更大的安全冗余。

特斯拉之所以采取纯视觉方案,是因为它有足够的数据训练做支撑。

目前全世界跑的特斯拉,它们的Autopilot已经累计超过30亿英里的里程。而特斯拉采用的是一种影子模式,那就是让自动驾驶系统跟随人类驾驶员的动作,来观察在各种情况下,人类是怎么做决策的,然后影子系统跟自己的算法做比对,再进行修正。相当于是驾驶员在教系统怎么开车。

从商业层面来说,特斯拉已经独占先机。其他车企很难再去做纯视觉方案。因为纯视觉方案虽然硬件成本低,但是依赖于长期、大量的数据训练。后来出的这些车,基本都选择了激光雷达,因为这种方案能够快速落地,关键是,配合其他传感器,能够实现较大的安全冗余。

尤其是对于传统车企来说,安全冗余是非常重要的。奔驰之所以能对自动驾驶事故敢于负法律责任,就是因为它对安全冗余极度有信心。

那么说到最后,纯视觉和激光雷达的路线分歧,其实是一个经济学问题。特斯拉有这个条件去做纯视觉,那它就可以去吹这个牛逼。

其他的车企,乖乖的用激光雷达就好了,快速实现量产,要比你花好几年的功夫去优化视觉算法来的实在。

从技术层面来说,视觉和激光雷达都是基于对光信号的捕捉,本质上是相通的。

只不过一个被动一个主动。

纯视觉的问题在于,单纯靠2D画面如何构建起3D世界,是个巨大的挑战。

AI经过数据训练,可以认知道路上的各类物体,但是这些物体的深度和速度信息,就难以准确判断。不过,据说特斯拉在秘密研发“伪激光雷达”,那就是从2D图像中提取深度信息。

这个我们以后再详细研究下。

而激光雷达看上去前景无限,但问题也是很多。先不说成本问题,在各种方案中,信号的衰减就是很大的挑战。在雨天、强光,甚至其他激光雷达的干扰下,激光雷达的成像距离会大大受限。

当然,凡事要用发展的眼光看,未来随着产业链的成熟,无论是TOF路线还是FMCW路线,都可能会分化出不同等级、不同性能的产品,来满足自动驾驶场景的需求。

从目前的量产车配置来看,视觉和激光雷达是相互补充的,而并非对立的。

只有特斯拉一家公司,坚持在纯视觉的路线上。

接下来,特斯拉是会从视觉方案中展现新的魔法,还是激光雷达拖鞋,是很值得玩味的。

x

-

特斯拉FSD深度解析:纯视觉路线真的可行吗? 2022-04-18 18:02

特斯拉FSD深度解析:纯视觉路线真的可行吗? 2022-04-18 18:02

-

英特尔宣布成立全新独立运营的FPGA公司——Altera 2024-03-01 12:47

英特尔宣布成立全新独立运营的FPGA公司——Altera 2024-03-01 12:47 -

哪吒汽车 All In AI,携手360集团推进大模型产品NETA GPT 上车 2024-03-01 17:21

哪吒汽车 All In AI,携手360集团推进大模型产品NETA GPT 上车 2024-03-01 17:21 -

15万有骁龙8295,16万配激光雷达,零跑C10发起“配置战” 2024-03-03 14:00

15万有骁龙8295,16万配激光雷达,零跑C10发起“配置战” 2024-03-03 14:00

京公网安备 11010502038466号

京公网安备 11010502038466号

关注官方微信

关注官方微信